- 65

- 271 374

Marc Deisenroth

Приєднався 13 жов 2011

Відео

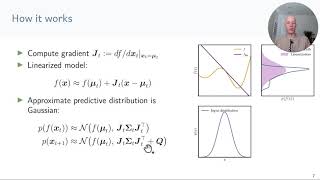

Iterative State Estimation in Non-linear Dynamical Systems Using Approximate Expectation Propagation

Переглядів 5452 роки тому

video summarizing TMLR paper available at openreview.net/forum?id=xyt4wfdo4J

Jackie Kay: Fairness for Unobserved Characteristics

Переглядів 3293 роки тому

Recent advances in algorithmic fairness have largely omitted sexual orientation and gender identity. We explore the concerns of the queer community in privacy, censorship, language, online safety, health, and employment to study the positive and negative effects of artificial intelligence on queer communities. These issues highlight a multiplicity of considerations for fairness research, such a...

Introduction to Integration in Machine Learning

Переглядів 1,7 тис.4 роки тому

Introduction to Integration in Machine Learning

12 Stochastic Gradient Estimators

Переглядів 1,3 тис.4 роки тому

Slides and more information: mml-book.github.io/slopes-expectations.html

05 Normalizing flows

Переглядів 4,8 тис.4 роки тому

Slides and more information: mml-book.github.io/slopes-expectations.html

06 Inference in Time Series

Переглядів 8394 роки тому

Slides and more information: mml-book.github.io/slopes-expectations.html

Inner Products (video 2): Dot Product

Переглядів 1,3 тис.5 років тому

Inner Products (video 2): Dot Product

Inner products (video 3): Definition

Переглядів 1 тис.5 років тому

Inner products (video 3): Definition

Projections (video 5): Example N-dimensional Projections

Переглядів 5815 років тому

Projections (video 5): Example N-dimensional Projections

Inner Products (video 4): Lengths and Distances, Part 1/2

Переглядів 8775 років тому

Inner Products (video 4): Lengths and Distances, Part 1/2

Statistics (video 6): Linear Transformations, Part 2/2

Переглядів 1,1 тис.5 років тому

Statistics (video 6): Linear Transformations, Part 2/2